KI-Verordnung (KI-VO) – Ratgeber für Unternehmen mit FAQ und Checklisten

Mit der KI-Verordnung der EU (abgekürzt “KI-VO”, englische Bezeichnung: “AI Act”) übernimmt die EU eine Vorreiterrolle bei der Regulierung der Künstlichen Intelligenz.

Die KI-VO betrifft praktisch alle die KI-Tools einsetzen oder entwickeln, seien es Unternehmen, Selbständige oder Behörden und je nach Einsatzart auch Privatpersonen.

Wie bedeutend die KI-VO ist, zeigen auch die Sanktionen, die für Anbieter von KI-Systemen bis zu 35 Mio. Euro oder bis zu 7% vom Jahresumsatz, je nachdem was höher ist, betragen können.

In dem folgenden Beitrag erhalten Sie daher alle wichtigsten Antworten zu der KI-Verordnung. Der Artikel ist als eine FAQ gestaltet, sodass Sie auch direkt zu den für Sie relevanten Punkten springen können. Für das volle Verständnis empfehle ich Ihnen jedoch, den Beitrag insgesamt zu lesen. Zum Abschluss erhalten Sie eine Checkliste für die Praxis.

Inhalt des Beitrags:

Was ist die KI-Verordnung?

Die KI-VO regelt umfassend die Entwicklung, den Vertrieb und den Einsatz von Künstlicher Intelligenz innerhalb der EU. Ihr Hauptziel ist es, vertrauenswürdige KI-Systeme zu fördern und gleichzeitig ein sicheres und innovationsfreundliches Umfeld zu schaffen.

Die KI-VO enthält Regeln, die für jede Art von KI gelten (z.B. die Notwendigkeit einer KI-Kompetenz, Artikel 4 KI-VO), strenge Vorschriften für Hochrisiko-KI-Systeme (z.B. im Beschäftigungskontext) sowie Verbote für bestimmte KI-Praktiken (z.B. Social Scoring). Da KI nicht nur ein hohes Zukunftspotential, sondern auch ein hohes Risikopotential birgt, werden Verstöße gegen diese Regeln mit hohen Bußgeldern geahndet, die sogar die Bußgelder der DSGVO übersteigen könnten.

In dem nachfolgenden Beitrag erhalten Sie Informationen zu den jeweiligen Regelungsbereichen, Anwendungsgebieten sowie Ausnahmen von der KI-Verordnung

Heißt es “KI-Verordnung” oder “KI-Gesetz”? Formell betrachtet handelt es sich um eine “KI-Verordnung”, da von der EU verbindlich für alle Mitgliedsstaaten festgelegte Regeln als Verordnungen bezeichnet werden (Art. 288 AEUV). Wenn der deutsche Gesetzgeber hingegen eine allgemein geltende Regelung erlässt, dann heißt es “Gesetz”.

Warum ist die Regulierung von KI durch die KI-VO notwendig?

Die Entwicklung und der Einsatz von Künstlicher Intelligenz birgt viele Risiken für Menschen. Zu diesen Risiken gehören insbesondere:

- Diskriminierung und Bias: KI-Systeme können bestehende Vorurteile und Diskriminierungen verstärken, insbesondere wenn sie mit voreingenommenen Daten trainiert werden.

- Datenschutzverletzungen: KI-Technologien können große Mengen an personenbezogenen Daten sammeln und analysieren, was das Risiko von Datenschutzverletzungen erhöht.

- Sicherheitsrisiken: KI-Systeme können Ziel von Cyberangriffen werden, was schwerwiegende Folgen für die Sicherheit von Daten und Infrastrukturen haben kann.

- Verlust menschlicher Autonomie: Die zunehmende Abhängigkeit von KI könnte die Entscheidungsfreiheit und Autonomie des Menschen einschränken.

- Mangel an Transparenz: Oftmals ist es schwierig nachzuvollziehen, wie KI-Entscheidungen getroffen werden, was zu einem Mangel an Transparenz und Verantwortlichkeit führt.

- Fehlfunktionen und Fehler: KI-Systeme sind nicht unfehlbar und können Fehlentscheidungen treffen, die gravierende Folgen haben können.

- Ethik und Moral: Der Einsatz von KI wirft zahlreiche ethische und moralische Fragen auf, insbesondere in Bezug auf die Entscheidungsfindung in kritischen Bereichen wie Medizin und Justiz.

Diese und weitere Risiken verdeutlichen die Notwendigkeit der KI-VO, um einen verantwortungsvollen und sicheren Umgang mit Künstlicher Intelligenz zu gewährleisten.

Welche Risikokategorien definiert die KI-VO für Künstliche Intelligenz?

Die KI-VO enthält Regulierungen zum Einsatz von KI, die auf einer Risikobetrachtung basieren. Dabei werden folgende Risikokategorien unterschieden:

- Unannehmbares Risiko – Verbotene KI-Praktiken: KI-Praktiken, die als unannehmbar risikoreich eingestuft werden, sind vollständig verboten. Dazu gehören beispielsweise KI-Anwendungen, die Menschen manipulieren oder kriminelles Verhalten aufgrund persönlicher Merkmale vorhersagen.

- Hohes Risiko – Hochrisiko-KI-Systeme: KI-Systeme, die ein hohes Risiko darstellen, unterliegen strengen Vorschriften. Dies umfasst Anforderungen an Datenqualität, Dokumentation und Transparenz sowie regelmäßige Prüfungen und Überwachung. Beispiele sind KI-Systeme im Gesundheitswesen für Diagnosezwecke oder Beurteilung von Bewerbern und Beschäftigten.

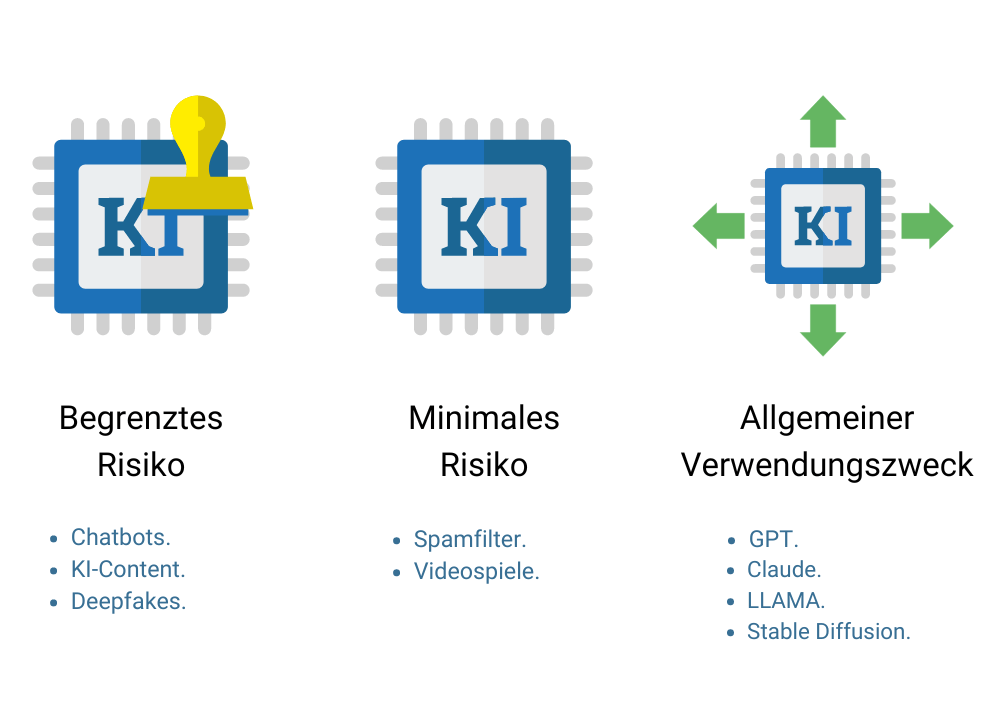

- KI-Systeme mit begrenztem Risiko: Systeme mit begrenztem Risiko müssen spezifische Transparenzanforderungen erfüllen. Benutzer müssen darüber informiert werden, dass sie mit einer KI interagieren, und in der Lage sein, deren Entscheidungen nachzuvollziehen. Beispiele hierfür sind Chatbots, die Kundensupport leisten oder Deepfakes.

- KI-Systeme mit minimalen Risiko: Für KI-Anwendungen, die ein minimales Risiko darstellen, gelten, bis auf die Pflicht zur KI-Kompetenz, keine spezifischen regulatorischen Anforderungen. Dies betrifft beispielsweise KI-Anwendungen zur Spamerkennung oder deren Einsatz in Videospielen.

- KI-Modelle mit allgemeinem Verwendungszweck: Diese Modelle, die für eine Vielzahl von Anwendungen genutzt werden und je nach Anwendung in alle der vorgenannten Kategorieen fallen können, unterliegen spezifischen Anforderungen, um sicherzustellen, dass sie sicher und zuverlässig sind. Dies umfasst Maßnahmen zur Sicherstellung der Robustheit, Genauigkeit und Fairness der Modelle sowie klare Vorgaben zur Transparenz und Nachvollziehbarkeit der Entscheidungen. Beispiele sind generative Sprachmodelle wie GPT4.0 oder Claude3.5.

Diese Risikokategorien ermöglichen eine differenzierte Regulierung, die den Schutz der Grundrechte gewährleistet und gleichzeitig Innovationen im Bereich der Künstlichen Intelligenz fördern soll.

Was versteht die KI-VO unter “Künstlicher Intelligenz” und “KI-Systemen”?

Die KI-VO stützt sich auf die Definition der KI durch die OECD und versteht KI als ein:

- maschinengestütztes System,

- das für einen in wechselndem Maße autonomen Betrieb ausgelegt ist,

- das nach seiner Einführung anpassungsfähig sein kann und

- das aus den erhaltenen Eingaben Ergebnisse wie etwa Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen hervorbringt, die physische oder virtuelle Umgebungen beeinflussen können.

Statt allgemein von “KI” zu sprechen, verwendet die die KI-VO entsprechend der vorstehenden Definition im Artikel 3 den Begriff “KI-System”. Damit wird klargestellt, dass es nicht um das eher abstrakte Konzept der “Künstlichen Intelligenz” geht, sondern um deren konkrete Anwendung und deren Auswirkungen auf den Menschen.

Daumenregel: Kurz zusammengefasst kann man eine KI daran erkennen, dass sie lernfähig ist und Aufgaben erledigt, die normalerweise menschliche Intelligenz erfordern. Sei es als Software, mittels Hardware oder einer Kombination von beiden.

Was ist ein “KI-Modell” im Sinne der KI-Verordnung?

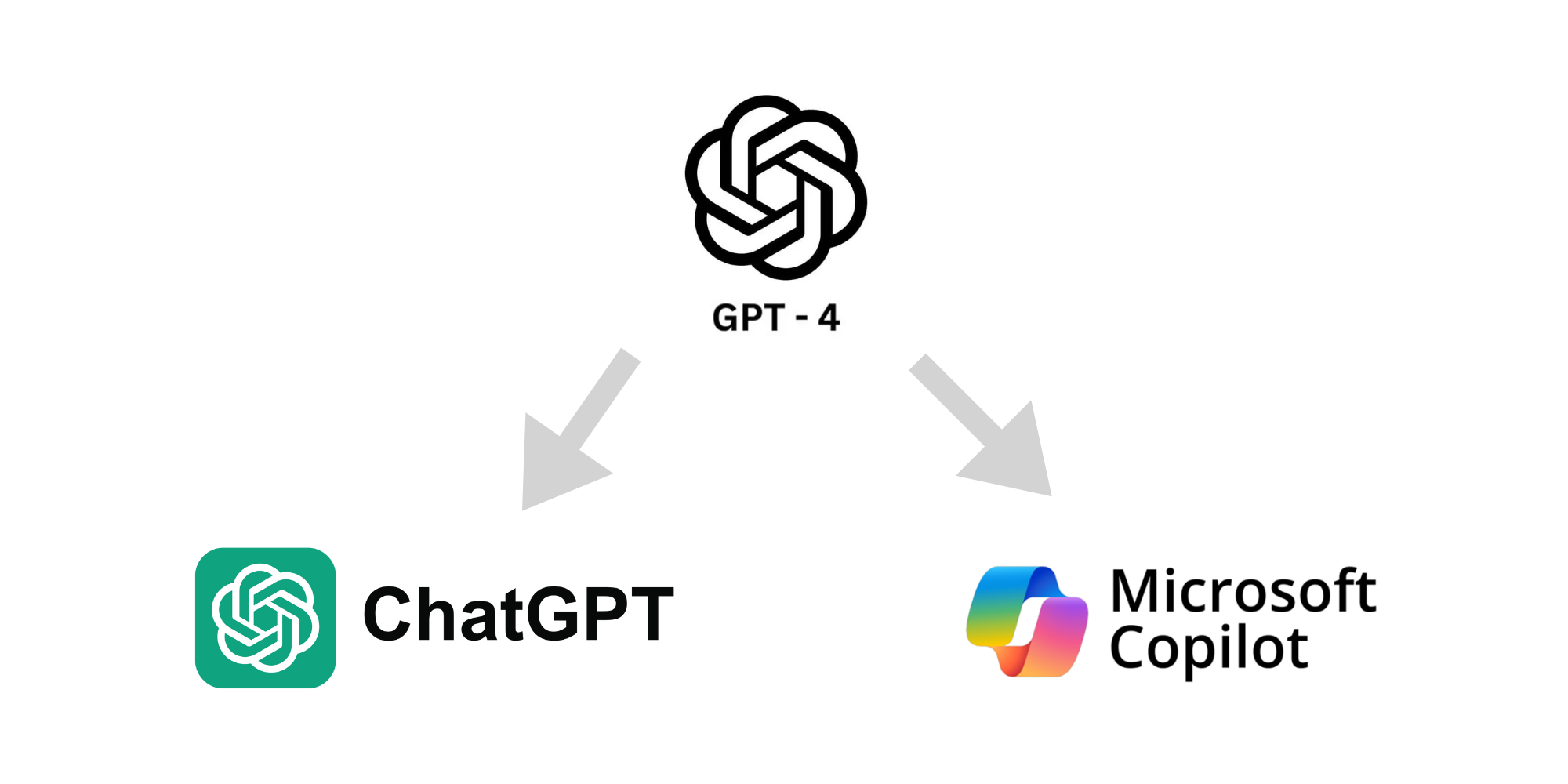

Neben dem Begriff “KI-System” verwendet die KI-Verordnung (KI-VO) auch den Begriff “KI-Modell”. Damit ist der Algorithmus gemeint, also die durch das Training erschaffene Denkgrundlage einer KI, die die Denkweise der KI bestimmt (z.B. sogenannte Large Language Models (LLMs), wie GPT-4, LLAMA oder Claude 3 sind unterschiedliche KI-Modelle).

Ein KI-Modell alleine oder zusammen mit weiteren KI-Modellen bildet die Grundlage eines KI-Systems. Zum Beispiel sind die KI-Modelle “GPT-4” und “Dall-E” die Basis für ChatGPT oder Microsofts Copilot.

Indem die KI-VO auch die Entwicklung von KI-Modellen regelt, soll sichergestellt werden, dass Risiken der KI bereits “an der Wurzel” vermieden werden. Dies umfasst insbesondere die Regelung von KI-Modellen mit allgemeinem Verwendungszweck (wie die oben genannten Beispiele), die in nahezu allen Bereichen eingesetzt werden können (Artikel 51-56 der KI-VO).

Gilt die KI-VO nur innerhalb der EU?

Die KI-VO gilt – so wie die DSGVO – nicht nur für KI, die in der EU entwickelt, vermarktet und eingesetzt wird, sondern auch, wenn sich der KI-Output in der EU auswirkt:

- Geltungsbereich innerhalb der EU: Die KI-VO gilt für Anbieter, Importeure oder Händler von KI-Systemen, die in der EU in Verkehr gebracht werden sowie Betreiber von KI-Systemen, die Ihren Sitz in der EU haben.

- Geltung für Drittländer: Auch Anbieter, Betreiber und Produkthersteller mit Sitz in Drittländern sind betroffen, wenn die KI-Ausgabe in der EU verwendet wird.

Wann kommt die KI-VO nicht zur Anwendung?

Die KI-VO gilt nicht für:

- Militärische und sicherheitsbezogene Zwecke: KI-Systeme, die ausschließlich für militärische, verteidigungs- oder nationale Sicherheitszwecke in Verkehr gebracht oder verwendet werden.

- Internationale Zusammenarbeit im Bereich der Strafverfolgung und justiziellen Zusammenarbeit: Behörden in Drittländern oder internationale Organisationen, die im Rahmen internationaler Zusammenarbeit mit der EU oder Mitgliedstaaten tätig sind.

- Forschung und Entwicklung: Wissenschaftliche Forschung und Entwicklung, bevor die KI-Systeme in Verkehr gebracht oder in Betrieb genommen werden.

- Persönliche Nutzung: KI-Systeme, die natürliche Personen im Rahmen einer ausschließlich persönlichen und nicht beruflichen Tätigkeit verwenden.

- Open Source KI: KI-Systeme, die unter freien und quelloffenen Lizenzen bereitgestellt werden, es sei denn, sie werden als Hochrisiko-KI-Systeme in Verkehr gebracht.

Wann müssen Privatpersonen die KI-VO beachten?

Die KI-VO betrifft zunächst jedermann. Sie gilt also auch, wenn KI nicht für geschäftliche, sondern für private Zwecke eingesetzt wird. So wird zum Anbieter im Sinne der KI-VO auch, wer ein KI-System unentgeltlich zur Verfügung stellt (Artikel 3 Nr. 3 KI-VO). Allerdings macht das Gesetz eine Ausnahme (Artikel 2 Abs. 10 KI-VO):

Diese Verordnung gilt nicht für die Pflichten von Betreibern, die natürliche Personen sind und KI‑Systeme im Rahmen einer ausschließlich persönlichen und nicht beruflichen Tätigkeit verwenden.

Gemeint ist damit eine KI-Nutzung, die Dritte nicht beeinträchtigt weil sie auf einen engen persönlichen Kreis beschränkt ist.

- Persönlich: Als persönlich ist nur ein Kreis von Personen gemeint, zu denen man eine engere, eine persönliche Bindung hat. Das können Familienmitglieder und Freunde sein, auch enge Arbeitskollegen, aber nicht pauschal eine Unternehmensabteilung und auch nicht Internet-Kontakte ohne vertiefte Beziehung.

- Nicht beruflich: Auch diese Einschränkung muss man unter dem Kriterium der schädlichen Außenwirkung bewerten. Nicht gemeint ist die persönliche Weiterbildung oder die Unterstützung bei der Formulierung einer Bewerbung. Ein beruflicher Einsatz von KI liegt dagegen vor, wenn man zum Beispiel im Homeoffice KI für den Arbeitgeber oder als Freiberufler nutzt.

Die Abgrenzung ist nicht immer einfach, kann aber anhand des Beispiels eines Deepfakes verdeutlicht werden.

Beispiel: Wer zum Beispiel Deepfakes einer Person zur eigenen Belustigung erstellt und sie innerhalb der Familie, Freunde oder engen Arbeitskollegen zeigt, muss die KI-VO nicht beachten. Wer Deepfakes dagegen für alle zugänglich im Internet oder Intranet des Arbeitgebers teilt, verlässt den persönlichen Rahmen und muss die Deepfakes als solche kennzeichnen (Art 50 Abs. 4 KI-VO).

Haushaltsausnahme der DSGVO: Das Prinzip, dass nur der persönliche Bereich vom Gesetz nicht erfasst ist, ist auch von der sogenannten “Haushaltsausnahme” der DSGVO bekannt, der die “Ausübung ausschließlich persönlicher oder familiärer Tätigkeiten” von den Pflichten der DSGVO freistellt (Art. 2 Abs. 2 lit. c) DSGVO). So käme im obigen Beispiel neben der KI-VO auch die DSGVO zur Anwendung und der Uploader müsste eine rechtliche Berechtigung, zum Beispiel eine Einwilligung, für die Veröffentlichung des Deepfakes vorweisen oder würde sonst DSGVO-Bußgelder und Schadensersatz riskieren.

Gilt die KI-VO auch für Open-Source-Software?

Die KI-Verordnung (KI-VO) gilt grundsätzlich nicht für Open-Source-Software, es sei denn, es handelt sich um spezifische Ausnahmen (Artikel 2 Abs. 12 KI-VO):

- Verbotene KI-Praktiken: KI-Systeme, die unethische oder gesetzlich verbotene Praktiken unterstützen.

- Hochrisiko-KI-Systeme: Systeme, die erhebliche Risiken für Gesundheit, Sicherheit oder Grundrechte bergen.

- Deepfake-Generierung: Die Transparenzpflichten bei Interaktionen mit Menschen, Erstellung synthetischer Inhalte und Kennzeichnung von Deepfakes müssen auch bei Open-Source-KI gewahrt werden.

Im Grunde bedeutet das, dass Open-Source-KI, die in eine dieser Kategorien fällt, genauso geprüft wird wie jede andere KI. Aber ansonsten kommt die KI-VO, z.B. die Pflicht zur KI-Kompetenz im Artikel 4, bei Open-Source-Software nicht zur Anwendung.

Welche Arten von KI-Systemen werden von der KI-VO reguliert?

Die KI-VO zielt darauf ab, verschiedene Arten der KI-Nutzung zu regulieren, basierend auf ihrem Risiko für die Gesellschaft:

- Verbotene KI-Praktiken: Aufgrund ihres hohen Risikos und potenziellen Schadens werden besonders schädliche Arten des KI-Einsatzes vollständig untersagt. Zu diesen verbotenen Praktiken gehören vor allem Systeme zur sozialen Bewertung, Echtzeit-Biometrie in öffentlichen Räumen oder schädliche Verhaltensmanipulationen (Artikel 5 KI-VO).

- Hochrisiko-KI-Systeme: Hochrisiko-KI-Systeme erfordern strenge Vorschriften und Kontrollen, wie KI in kritischen Infrastrukturen, medizinische Geräte und biometrische Identifikationssysteme wie Gesichtserkennung in öffentlichen Räumen. Diese KI-Systeme unterliegen umfangreichen Regelungen und Verpflichtungen (Artikel 6-49 KI-VO).

- KI-Modelle mit allgemeinem Verwendungszweck (Generelle KI-Modelle): Generelle KI-Modelle (General Purpose AI) sind KI-Systeme, die sich für beliebige Aufgaben einsetzen lassen, z.B. auch für Hochrisiko-KI-Systeme oder verbotene KI-Praktiken. Der Gesetzgeber regelt daher nicht nur den konkreten Einsatz der generellen KI als KI-System, sondern schon die KI-Modelle selbst (Artikel 51-56 der KI-VO).

- KI-Systeme ohne spezielle Regulierung: Beim Einsatz von allen KI-Systemen müssen die Anforderungen an die KI-Kompetenz (Artikel 4 KI-VO) und die Transparenzanforderungen, z.B. Kennzeichnung von Deepfakes, beachtet werden (Artikel 50 KI-VO).

Welche KI-Praktiken sind durch die KI-VO vollständig verboten?

Die KI-VO verbietet “das Inverkehrbringen, die Inbetriebnahme oder die Verwendung eines KI-Systems”, die zu den folgenden Zwecken eingesetzt, bzw. die genannte Wirkung haben werden (Artikel 5 KI-VO):

- Erhebliche Schäden verursachende Verhaltensänderung und Entscheidungsbeeinflussung: Untersagt werden zunächst KI-Praktiken, die als Folge das Verhalten einer Person oder einer Gruppe von Personen so wesentlich verändern, dass sie Entscheidungen treffen, die ihnen einen erheblichen Schaden zufügen könnten. Dabei werden explizit die folgenden Verhaltensweisen untersagt:

- Unterschwellige Beeinflussung: Verboten ist der Einsatz von “Techniken der unterschwelligen Beeinflussung außerhalb des Bewusstseins oder absichtlich manipulative oder täuschende Techniken“, um die vorstehenden Zwecke zu erreichen. Beispiel: Ein Online-Shop verwendet eine KI, die auf Grundlage des Nutzerprofilings Texte und Grafiken individuell auf potenzielle Kunden anpasst, um sie so zu einem Kauf zu verleiten.

- Schwächen oder Schutzbedürftigkeit: Verboten ist ebenfalls das Ausnutzen der Schwächen oder Schutzbedürftigkeit einer Person oder Gruppe aufgrund von Alter, Behinderung oder sozialer und wirtschaftlicher Situation mit den vorgenannten Folgen. Beispiel: Eine Kreditkartenfirma setzt eine KI ein, die gezielt ältere Menschen mit niedrigem Einkommen anspricht und mittels eines KI-Chatbots mit Emotionserkennung dazu verleitet, hochverzinsliche Kredite aufzunehmen.

- Unterschwellige Beeinflussung: Verboten ist der Einsatz von “Techniken der unterschwelligen Beeinflussung außerhalb des Bewusstseins oder absichtlich manipulative oder täuschende Techniken“, um die vorstehenden Zwecke zu erreichen. Beispiel: Ein Online-Shop verwendet eine KI, die auf Grundlage des Nutzerprofilings Texte und Grafiken individuell auf potenzielle Kunden anpasst, um sie so zu einem Kauf zu verleiten.

- Soziale Bewertung (“Social Scoring”): KI-Systeme zur Bewertung oder Klassifizierung von Personen oder Gruppen über einen bestimmten Zeitraum basierend auf ihrem Sozialverhalten oder persönlichen Eigenschaften, wenn dies zu ungerechtfertigter oder unverhältnismäßiger Benachteiligung führt. Diese Vorschrift richtet sich vor allem an staatliche Stellen, kann aber auch “im Kleinen” erfolgen. Beispiel: Ein Unternehmen beobachtet die Beschäftigten im Verhalten miteinander und vergibt Verhaltenspunkte, die sich beim Gehalt oder bei Beförderungen bemerkbar machen.

- Vorhersage krimineller Aktivitäten: KI-Systeme zur Bewertung oder Vorhersage des Risikos, dass eine Person eine Straftat begeht, basierend auf Profiling und Persönlichkeitsmerkmalen, ausgenommen Systeme zur Unterstützung menschlicher Bewertungen, die auf objektiven Tatsachen beruhen. Auch in diesem Fall richtet sich die Vorschrift vor allem an staatliche Stellen, kann aber auch Unternehmen betreffen. Beispiel: Eine KI bewertet das Risiko, dass jemand eine Straftat begeht, basierend auf seinem Wohnort und seiner Online-Aktivität, und verhindert dadurch den Zugang zu bestimmten Jobs oder Dienstleistungen.

- Gesichtserkennungsdatenbanken: KI-Systeme, die Gesichtserkennungsdatenbanken durch ungezieltes (also zufälliges) Auslesen von Bildern aus dem Internet oder Überwachungskameras erstellen oder erweitern. Beispiel: Eine KI analysiert Gesichter in Überwachungskameras und erstellt ohne Zustimmung der Betroffenen eine Datenbank, die von Sicherheitsfirmen verwendet wird.

- Emotionserkennung am Arbeitsplatz oder in Bildungseinrichtungen: KI-Systeme zur Ableitung von Emotionen am Arbeitsplatz oder in Bildungseinrichtungen, außer sie werden aus medizinischen oder sicherheitstechnischen Gründen eingesetzt. Beispiel: Eine KI in einem Bewerbungsgespräch analysiert die Gesichtsausdrücke der Kandidaten, um deren Emotionen zu bewerten und trifft darauf basierend Einstellungsentscheidungen.

- Biometrische Überwachung: Untersagt wird die biometrische Identifizierung in der Öffentlichkeit zu Strafverfolgungszwecken, außer in konkreten Gefahren (z.B. Terrorismus und Anhang II zur KI-VO).

- Biometrische Kategorisierung: Ebenfalls werden KI-Systeme, die Personen auf Grundlage biometrischer Daten kategorisieren, um Rückschlüsse auf ihre Rasse, politischen Meinungen, Gewerkschaftszugehörigkeit, religiösen Überzeugungen, ihr Sexualleben oder ihre sexuelle Orientierung zu ziehen, untersagt. Beispiel: Ein KI-System kategorisiert Menschen in einem Einkaufszentrum basierend auf ihrer Gesichtsanalyse, um personalisierte Werbung anzuzeigen, die auf ihre vermeintliche religiöse Zugehörigkeit oder politische Meinung abzielt.

In der unternehmerischen Praxis werden die Verbote vor allem im Rahmen des Personalmanagements (z.B. Emotionserkennung) oder des Marketings (unterschwellige Beeinflussung und Ausnutzen von Schwächen) relevant sein. In diesen Bereichen eingesetzte Beschäftigte sollten zur Vermeidung von erheblichen Bußgeldern in jedem Fall über diese Grenzen unterrichtet und auf deren Einhaltung verpflichtet werden.

Wer muss die KI-VO beachten?

Die KI-Verordnung müssen praktisch alle Personen beachten, die KI nicht nur innerhalb eines persönlichen und privaten Rahmens einsetzen (Artikel 3 – 8). Der Unterschied besteht im Umfang der Pflichten, die auf die einzelnen Akteure zukommen:

- Anbieter: „Anbieter“ ist jedermann, sei es eine einzelne Person, ein Unternehmen oder eine Behörde, die ein KI-System oder ein KI-Modell mit allgemeinem Verwendungszweck entwickelt oder entwickeln lässt und es unter ihrem eigenen Namen oder ihrer Handelsmarke in Verkehr bringt oder in Betrieb nimmt. Beispiel: OpenAI (ChatGPT), Google (Gemini).

- Einführer: Einführer führen KI-Systeme aus Nicht-EU-Ländern in die EU ein. Sie müssen überprüfen, ob die importierten Systeme den europäischen Vorschriften entsprechen, und sicherstellen, dass diese Systeme ordnungsgemäß dokumentiert und rechtskonform sind. Wer insbesondere Hochrisiko-KI-Systeme von KI-Systemen, die von Nicht-EU-Anbietern angeboten werden, in der EU/EWR zur Verfügung stellt, muss sicherstellen, dass die Anbieter die gleichen wie für EU-Anbieter geltenden Pflichten erfüllen (z.B. dass das Konformitätsbewertungsverfahren gemäß Artikel 43 KI-VO durchgeführt wurde und entsprechende Dokumentation vorhanden ist, Art. 23 KI-VO).

- Händler: Händler vertreiben KI-Systeme innerhalb der EU. Händler müssen entsprechend Artikel 24 KI-VO prüfen, ob KI-Systeme außerhalb der EU/EWR mit der erforderlichen CE-Kennzeichnung versehen sind und ob eine Kopie der in Artikel 47 genannten EU-Konformitätserklärung und Betriebsanleitungen beigefügt ist.

- Betreiber: Als „Betreiber“ werden alle bezeichnet, die ein KI-System in eigener Verantwortung verwenden, es sei denn, das KI-System wird im Rahmen einer persönlichen und nicht beruflichen Tätigkeit verwendet. Betreiber müssen die Systeme gemäß den Anweisungen des Anbieters nutzen, die Sicherheitsstandards einhalten, die Leistung der Systeme überwachen und bei Problemen die entsprechenden Behörden informieren.

- Bevollmächtigte: “Bevollmächtigte” sind EU-ansässige Vertreter eines Nicht-EU-Anbieters eines KI-Systems oder eines KI-Modells, die für die Anbieter die Pflichten der KI-VO wahrnehmen.

Bitte beachten Sie, dass diese Abgrenzungen auch fluktuieren und sich überlappen können. So kann zum Beispiel ein Unternehmen, das zunächst eine fremde KI-Software nur betreibt, zum Anbieter werden, wenn es diese weiterentwickelt und auf dem Markt zur Verfügung stellt.

Unterscheidung zwischen Anbieter und Betreiber

Unternehmen oder Behörden nutzen KI-Systeme häufig nicht nur durch konkrete Anwendungen wie z.B. Chatbots oder als in Office-Software integrierte Assistenten. Oftmals werden KI-Dienste mittels Programmierschnittstellen (englisch „API“) in die eigene Software ein-gebunden, oder vorhandene KI-Modelle werden mit eigenen Daten auf die spezifischen Bedürfnisse angepasst, z.B. durch sogenanntes Fi-netuning.

In solchen Konstellationen stellt sich die Frage, ab wann von einem neuen KI-System gesprochen werden muss, dessen Anbieter man wird. Diese Frage wird in der KI-Verordnung (KI-VO) nur für Hochrisiko-KI-Systeme beantwortet, ist darüber hinaus jedoch weniger klar geregelt:

- Hochrisiko-KI-Systeme: Laut Art. 25 KI-VO wird jeder automatisch zum Anbieter eines KI-Systems, der es im eigenen Namen oder un-ter eigener Marke auf den Markt bringt, ein bestehendes Hochrisi-ko-KI-System wesentlich verändert oder ein KI-System oder dessen Zweck so verändert, dass es zu einem Hochrisiko-KI-System wird.

- Andere KI-Systeme: Es besteht keine rechtliche Klarheit darüber, ob bereits die Bereitstellung eines externen KI-Systems mittels ei-gener Software oder eigener Nutzerschnittstellen zu einer Anbie-terstellung führt (z.B. beim Angebot einer Bildbearbeitungs-Applikation, die im Hintergrund mittels einer Schnittstelle zu DALL-E arbeitet). Entscheidend könnte dabei sein, ob Transparenz über das genutzte KI-System besteht, welche technischen Beiträge geleistet wurden, ob das Risiko für Dritte erhöht wurde und wel-cher Gestaltungsspielraum vorhanden war (z.B. könnte ein Fi-netuning innerhalb der vom KI-System-Anbieter gestellten Para-meter gegen eine Anbieterstellung sprechen).

Diese Unsicherheit mag unbefriedigend erscheinen, jedoch werden die relevanten Pflichten der KI-VO nur im Fall von Hochrisiko-KI-Systemen aktiv. Darüber hinaus müssen Anbieter lediglich die Transparenzpflichten beachten (Artikel 52 KI-VO), d.h.:

- KI-Interaktionen müssen als solche erkennbar sein.

- KI-Inhalte müssen maschinenlesbar als solche gekennzeichnet werden. Werden die Ergebnisse jedoch im Hintergrund von exter-nen KI-Anbietern bezogen, enthalten sie in der Regel bereits die entsprechenden Kennzeichnungen.

Muss ich die KI-VO berücksichtigen, wenn ich lediglich KI-Tools nutzen?

Die KI-Verordnung gilt nicht nur für Entwickler oder Händler von KI-Systemen, sondern auch für deren geschäftliche Nutzer (von der KI-VO als “Betreiber” bezeichnet). Bereits bevor KI-Tools oder KI-Verfahren eingesetzt werden, die KI implementieren, muss geprüft werden, ob Sie der KI-VO unterfallen und die einschlägigen Pflichten beachtet werden.

Dazu müssen Sie die KI-Tools vor allem zuerst der richtigen Risikokategorie zuordnen und die entsprechenden Regelungen beachten. Da Unternehmen KI-Tools in verschiedenen Bereichen einsetzen, kann die jeweilige Zuordnung gemäß der KI-Verordnung variieren:

- IT

- Beispiel: Spam-Filter mit KI-gestützter Erkennung.

- KI-VO-Kategorie: Nicht besonders geregelt, Beachtung KI-Kompetenz (Art. 4 KI-VO) und Transparenzpflichten (Art. 50 KI-VO).

- Kundendienst und Support

- Beispiel: KI-basierte Chatbots und virtuelle Assistenten.

- KI-VO-Kategorie: Nicht besonders geregelt, Beachtung KI-Kompetenz (Art. 4 KI-VO) und Transparenzpflichten (Art. 50 KI-VO).

- Personalwesen

- Beispiel: Vorauswahl von Bewerbern, Analyse von Lebensläufen und Durchführung von Interviews durch KI.

- KI-VO-Kategorie: Hochrisiko-KI-System. Diese Systeme können wesentliche Entscheidungen über den beruflichen Werdegang von Personen beeinflussen und dürfen nur bei Beachtung der Pflichten gem. Artikel 26 KI-VO eingesetzt werden.

- Marketing und Vertrieb

- Beispiel: Analyse von Kundendaten und Erstellung personalisierter Marketingkampagnen.

- KI-VO-Kategorie: Nicht besonders geregelt, Beachtung KI-Kompetenz (Art. 4 KI-VO) und Transparenzpflichten (Art. 50 KI-VO).

- Gesundheitswesen

- Beispiel: Diagnosestellung, Analyse von Patientenakten und Erstellung von Behandlungsplänen.

- KI-VO-Kategorie: Hochrisiko-KI-System. Diese Systeme können wesentliche Entscheidungen über den beruflichen Werdegang von Personen beeinflussen und müssen daher strengen Anforderungen der Art. 6-49 KI-VO genügen.

- E-Commerce

- Beispiel: Eine KI wertet ein verhaltens- und interessensbasiertes Profil eines Kunden aus, um z.B. kurz und unterhalb der Wahrnehmungsschwelle Bilder ein, die den Kunden laut der Prognose zum Einkauf animieren sollen.

- KI-VO-Kategorie: Verbotene KI-Praktik, da unterschwelligen Beeinflussung außerhalb des Bewusstseins einer Person, zudem mit manipulativer Absicht erfolgt und z.B. die Käufe so zu ungewollter finanzieller oder psychischer Belastung führen können (Artikel 5 Abs. 1 lit a) KI-VO).

Wann liegt ein Hochrisiko-KI-System vor?

Wann ein KI-System ein Hochrisiko-KI-System im Sinne der KI-Verordnung darstellt und dementsprechend die damit einhergehenden Pflichten der KI-Verordnung beachtet werden müssen, ergibt sich aus dem Artikel 6 und Anhang III zur KI-Verordnung. Es gibt drei Möglichkeiten, wie die Gesetzgebung vorsieht, dass KI-Systeme als „hochriskant“ eingestuft werden:

- EU-Rechtlich einheitlich regulierte Produkte: Wenn das KI-System entweder selbst ein Produkt oder Sicherheitskomponente eines Produktes ist, die von den Harmonisierungsvorschriften der EU erfasst sind (Anhang I zur KI-VO). Dazu gehören u.a. medizinische Geräte, industrielle Maschinen, Spielzeug, Flugzeuge oder Autos.

- Aufgezählte KI-Einsatzbereiche: Wenn das KI-System der Beschreibung für gelistete „hochriskante“ KI-Systeme in Anlage III der KI-VO entspricht.

Zu den Hochrisiko-KI-Systemen laut Anlage III der KI-VO zählen KI-Systeme mit den folgenden Funktionen und Einsatzbereichen:

- Biometrie

- Biometrische Fernidentifizierung: z.B. Gesichtserkennung in öffentlichen Bereichen, außer sie dient alleine der Identifizierung von Personen (z.B. Fingerscanner).

- Biometrische Kategorisierung (sofern diese nicht schon nach Artikel 45 KI-VO verboten ist).

- Emotionserkennung: z.B. Erkennung von Emotionen am Arbeitsplatz.

- Kritische Infrastruktur

- Verwaltung und Betrieb kritischer digitaler Infrastruktur: z.B. Steuerung eines Stromnetzes, Straßenverkehr, Wasser-, Gas-, Wärme- oder Stromversorgung: z.B. Überwachung und Steuerung von Versorgungsnetzen.

- Allgemeine und berufliche Bildung

- Zulassung und Bewertung von Personen in Bildungseinrichtungen: z.B. automatisierte Bewertung von Prüfungen.

- Beschäftigung und Personalmanagement:

- Einstellung, Beförderung und Kündigung von Arbeitsverhältnissen: z.B. KI-gestützte Vorauswahl von Bewerbungen.

- Grundlegende private und öffentliche Dienste

- Kreditwürdigkeitsprüfung: z.B. Bewertung von Kreditanträgen bei Banken.

- Risikobewertung bei Versicherungen: z.B. Analyse von Kranken- und Lebensversicherungsanträgen.

- Strafverfolgung

- Lügendetektoren: z.B. KI-Systeme zur Erkennung von Lügen.

- Risikobewertung von Straftaten: z.B. Vorhersage zukünftiger Straftaten.

- Migration, Asyl und Grenzkontrolle:

- Prüfung von Asyl- und Visumanträgen: z.B. automatisierte Analyse von Asylanträgen.

- Sicherheitsrisikobewertung: z.B. Identifizierung potenzieller Sicherheitsrisiken an Grenzen.

- Rechtspflege und demokratische Prozesse

- Unterstützung bei rechtlichen Entscheidungen: z.B. KI-Systeme zur Analyse von Beweismitteln.

- Beeinflussung von Wahlergebnissen: z.B. Systeme zur Überwachung und Analyse von Wahldaten.

Ausnahmsweise handelt es sich in den folgenden Fällen um kein Hochrisiko-KI-System:

- Militärische, Verteidigungs- oder Sicherheitszwecke.

- Wissenschaftliche Forschung und Entwicklung.

- Private Nutzung: Für Individuen, die KI-Systeme in rein persönlicher, nicht beruflicher Tätigkeit verwenden.

- Kein signifikantes Risiko: Gilt, wenn die Systeme keine bedeutenden Risiken für Gesundheit, Sicherheit oder Grundrechte darstellen.

Allerdings gelten diese Ausnahmen wiederum nicht, wenn ein Profiling von Individuen durchführt wird

Aktualisierung möglich: Die Definition ist in den Anhang III ausgelagert worden, da dieser Anhang aktualisiert werden kann, ohne das eigentliche Gesetz zu verändern. Das bedeutet für Sie, dass Sie, falls Sie KI-Systeme einsetzen, die Aktualisierungen des Anhangs III stets beachten müssen.

Welche Anforderungen werden an Anbieter von Hochrisiko-KI-Systemen gestellt?

Wird der KI Einsatz Von der KI-VO als einen Hochrisiko-KI-System eingestuft, dann muss dessen Anbieter eine Vielzahl von Pflichten beachten (Artikel 6 bis 49 DSGVO):

- Risikomanagementsystem (Artikel 9):

- Detaillierte Risikobewertung und -analyse

- Durchführung von Risikomanagementmaßnahmen

- Datengovernance und Datenmanagement (Artikel 10):

- Strikte Einhaltung der Datenschutzgesetze

- Sicherstellung der Datenqualität, -integrität und -sicherheit

- Auswahl von geeigneten Datensätzen, um Verzerrungen zu minimieren

- Prüfung und Validierung der Daten

- Sicherstellung der Nachvollziehbarkeit und Rückverfolgbarkeit der Datenquellen

- Technische Dokumentation und Protokollierung (Artikel 11, 12):

- Umfangreiche technische Dokumentation einschließlich Datenquellen, Algorithmen, Designentscheidungen und Validierungsmethoden.

- Das KI-System muss über eine Protokollierung verfügen, damit das Funktionieren des Hochrisiko-KI‑Systems in einem der Zweckbestimmung des Systems angemessenen Maße rückverfolgbar ist.

- Transparenzanforderungen (Artikel 13):

- Artikel 13 der KI-Verordnung legt fest, dass Anbieter von Hochrisiko-KI-Systemen sicherstellen müssen, dass diese Systeme so konzipiert und entwickelt werden, dass sie verständliche und transparente Informationen bereitstellen, damit die Betreiber ihre Funktionsweise und die erzielten Ergebnisse nachvollziehen können.

- Bereitstellung von Betriebsanleitungen und Erklärungen zu den Entscheidungsprozessen des Systems für die Betreiber.

- Menschliche Aufsicht (Artikel 14):

- Kontinuierliche Überwachung und Berichterstattung

- Regelmäßige Audits und Überprüfungen durch unabhängige Stellen

- Genauigkeit, Robustheit und Cybersicherheit (Artikel 15):

- Sicherstellen der Genauigkeit und Zuverlässigkeit der Systeme.

- Maßnahmen zur Stabilität und Resilienz gegen Störungen.

- Schutz gegen Cyberangriffe und unbefugten Zugriff.

- Korrekturmaßnahmen und Informationspflichten (Artikel 20):

- Anbieter müssen geeignete Korrekturmaßnahmen ergreifen, wenn ein Hochrisiko-KI-System nicht den Anforderungen entspricht.

- Anbieter sind verpflichtet, schwerwiegende Vorfälle und Fehlfunktionen den zuständigen Behörden zu melden.

- Anbieter müssen Benutzer und Betreiber über diese Vorfälle informieren und ihnen notwendige Anweisungen zur Abhilfe geben

- Konformitätsbewertung (Artikel 43):

- Durchführung einer Konformitätsbewertung durch eine benannte Stelle (Dritte).

- Zertifizierung und Kennzeichnung (Artikel 49):

- Notwendigkeit einer CE-Kennzeichnung und Zertifizierung vor dem Inverkehrbringen

In der Regel werden Sie kein Hochrisiko-KI-System auf dem Markt anbieten, sondern ein solches von einem anderen Anbieter beziehen. In diesem Fall treffen Sie nicht die oben genannten, sondern spezielle Betriebspflichten.

Welche Anforderungen werden an Betreiber von Hochrisiko-KI-Systeme gestellt?

In der Praxis, werden nur die wenigsten Unternehmen selbst Hochrisiko-KI-Systeme erstellen oder anbieten. Vielmehr werden sie derartige Leistungen, wie zum Beispiel biometrische Systeme, von anderen Unternehmen beziehen.

Anders als der Anbieter des KI-Systems müssen sie dann als dessen Betreiber zwar nicht die Grundlagen des KI-Systems prüfen. Jedoch müssen sie sicherstellen, dass die folgenden Pflichten im Rahmen der Implementierung und des Betriebs des KI-Systems beachtet werden (Artikel 26 KI-VO):

- Betriebsanleitung und Technische sowie organisatorische Maßnahmen: Betreiber müssen sicherstellen, dass Hochrisiko-KI-Systeme gemäß den Betriebsanleitungen verwendet werden. Dies beinhaltet die Implementierung geeigneter technischer und organisatorischer Maßnahmen, um die Sicherheit und Genauigkeit des Systems zu gewährleisten.

- Kompetente Aufsicht (“KI-Beauftragte:r”): Die menschliche Aufsicht über die Hochrisiko-KI-Systeme muss durch geschulte und befugte Personen erfolgen.

- Datenkontrolle: Betreiber müssen sicherstellen, dass die Eingabedaten der Zweckbestimmung des KI-Systems entsprechen und korrekt sind.

- Überwachung und Berichterstattung: Es ist notwendig, die Hochrisiko-KI-Systeme kontinuierlich zu überwachen und alle Risiken oder Vorfälle zu melden.

- Protokollaufbewahrung: Automatisch erzeugte Protokolle müssen für mindestens sechs Monate gespeichert werden. Diese Protokolle dienen der Nachverfolgbarkeit und Überprüfung der Systemaktivitäten.

- Information der Arbeitnehmer: Arbeitnehmer müssen vorab informiert werden, wenn Hochrisiko-KI-Systeme am Arbeitsplatz eingesetzt werden. Dies stellt sicher, dass die Mitarbeiter über die Nutzung solcher Systeme und deren Auswirkungen informiert sind.

- Registrierungspflichten: Betreiber müssen die Registrierungspflichten gemäß Artikel 49 einhalten. Dies umfasst die ordnungsgemäße Registrierung der Hochrisiko-KI-Systeme bei den zuständigen Behörden.

- Datenschutz-Folgenabschätzung: Betreiber müssen die von den KI-Anbietern bereitgestellten Informationen nutzen, um Datenschutz-Folgenabschätzungen gemäß Art. 35 DSGVO durchzuführen.

Der Einsatz von Hochrisiko-KI-Systemen bedeutet daher nicht nur, wenn man sie auf den Markt bringt, sondern auch, wenn man sie einsetzt, dass sie mit einem erhöhten Verwaltungsaufwand verbunden sind. Wenn Hochrisiko-KI-Systeme eingesetzt werden, dann sollte auf jeden Fall eine kompetente Person als KI-Beauftragte:r bestellt werden.

Welche speziellen Regelungen gelten für generelle KI?

KI-Modelle mit einem allgemeinen Verwendungszweck (General Purpose AI Models, GPAIM) sind vielseitige KI-Modelle, die in einer Vielzahl von Anwendungen und Kontexten eingesetzt werden können.

Ein Beispiel für ein KI-Modell mit einem allgemeinen Verwendungszweck ist GPT-4, das für verschiedenste Aufgaben wie Textgenerierung, Übersetzung und Beantwortung von Fragen verwendet werden kann. Im Gegensatz dazu ist ein spezielles KI-Modell, wie ein medizinisches Diagnosetool zur Erkennung von Lungenkrebs auf Röntgenbildern, nur für eine spezifische Anwendung entwickelt und optimiert.

Das KI-Gesetz war bereits in der Gesetzgebungsphase, als ChatGPT auf der Bildfläche auftauchte. Das Problem war, dass dieses KI-Modell allgemein einsetzbar war und damit nicht in das Risikoklassensystem der KI-VO passte. Daher hat der Gesetzgeber zusätzliche Regeln eingeführt, die Speziell für Entwickler der allgemein einsetzbaren KI Modelle gelten.

Diese Regeln müssen von den Anbietern von KI-Modellen mit allgemeinem Verwendungszweck beachtet werden, d.h. nur von den KI-Entwicklern selbst. Zu diesen Pflichten gehören u.a.:

- Transparenzanforderungen: Die Anbieter müssen klar kommunizieren, dass es sich um ein allgemeines KI-System handelt und welche potenziellen Risiken und Einsatzbereiche existieren.

- Sicherheitsmaßnahmen: Implementierung robuster Sicherheitsvorkehrungen, um den Missbrauch des Systems zu verhindern.

- Nachhaltigkeit und Wartung: Regelmäßige Überprüfung und Aktualisierung des Systems, um sicherzustellen, dass es sicher und effektiv bleibt.

- Datenmanagement: Sorgfältiger Umgang mit den Trainingsdaten, einschließlich Datenschutz und ethischen Erwägungen.

- Aufklärung und Instruktion: Bereitstellung von Informationen und Schulungen für die Anbieter, die diese Modelle in ihre Systeme einbinden wollen.

- Meldung und Reaktion auf Vorfälle: Etablierung eines Systems zur Meldung von und Reaktion auf Vorfälle, die durch die Nutzung des KI-Systems entstehen könnten.

Sofern Sie jedoch nicht selbst eigene KI-Modelle entwickeln, werden Sie in der Praxis mit diesen Pflichten sehr wahrscheinlich wenig zu tun haben.

Welche Transparenzanforderungen werden an alle KI-Systeme gestellt?

Auch wenn der KI-Einsatz weder eine verbotene KI-Praktik darstellt noch es sich um ein Hochrisiko-KI-System handelt, müssen dennoch die für alle KI-Systeme geltenden Pflichten beachtet werden (Art. 50 KI-VO):

- Transparenzpflichten bei Interaktion: Anbieter von KI-Systemen müssen sicherstellen, dass natürliche Personen informiert werden, wenn sie mit einem KI-System interagieren, es sei denn, dies ist offensichtlich.

- Kennzeichnung von KI-Ergebnissen: Anbieter von KI-Systemen müssen sicherstellen, dass Ausgaben des KI‑Systems in einem maschinenlesbaren Format gekennzeichnet und als künstlich erzeugt oder manipuliert erkennbar sind. D.h., dass alle KI-Ergebnisse in den Meta-Daten als solche gekennzeichnet werden.

- Kennzeichnungspflicht bei Deepfakes: Betreiber (also in dem Kontext Nutzer) eines KI‑Systems, das Bild-, Ton- oder Videoinhalte erzeugt oder manipuliert, die ein Deepfake sind, müssen offenlegen, dass die Inhalte künstlich erzeugt oder manipuliert wurden.

Weitergabe von Kennzeichnungspflichten an Nutzer von KI-Werkzeugen: Auf den ersten Blick werden bloß die Anbieter von KI-Werkzeugen nur zu einer Kennzeichnungspflicht bei Deepfakes verpflichtet. Allerdings geben die Anbieter von KI-Systemen ihre Pflichten an ihre Kunden weiter. Das heißt, wenn zum Beispiel ein Anbieter einen KI-Chatbot für Unternehmen bereitstellt, ist er verpflichtet, dass dieser KI-Bot immer als solcher erkennbar ist. Dementsprechend wird der Anbieter seine Kunden, die den KI-Bot betreiben, dazu verpflichten, dass der KI-Bot als solcher erkennbar ist. Dasselbe gilt bei KI-Ergebnissen. Das ist auch der Grund, warum Plattformen wie zum Beispiel Instagram dazu übergehen, Nutzer zu verpflichten, KI-Ergebnisse zu kennzeichnen oder es ohnehin von sich aus zu machen.

Was sind Deepfakes und wie müssen sie gekennzeichnet werden?

Als “Deepfakes” bezeichnet die KI-VO (Artikel 3 Nr. 60 KI-VO)

einen durch KI erzeugten oder manipulierten Bild-, Ton- oder Videoinhalt, der wirklichen Personen, Gegenständen, Orten, Einrichtungen oder Ereignissen ähnelt und einer Person fälschlicherweise als echt oder wahrheitsgemäß erscheinen würde.

Deepfakes sind also Bilder oder Videos, die dann entstehen, wenn Sie von der KI verlangen, dass die Ergebnisse fotorealistisch oder “wie echt” erscheinen sollen. Daher sollten Sie unbedingt die folgenden Aspekte von Deepfakes berücksichtigen:

- Irreführungsabsicht nicht relevant: Wichtig, es ist nicht notwendig, dass mit Deepfakes eine Täuschungs- oder Irreführungsabsicht verbunden wird. So kann z.B. ein zu Illustrationszwecken eines Newsbeitrags fotorealistisch generiertes KI-Bild ein Deepfake im Sinne des Gesetzes sein.

- Kennzeichnungspflicht: Sie müssen sicherstellen, dass ein Deepfake stets als KI-Erzeugnis gekennzeichnet wird (Artikel 50 Abs. 4 KI-VO).

- Hohe Sanktion: Bei Verstoß droht ein Bußgeld in Höhe von 15 Millionen Euro oder 3 % des weltweiten Jahresumsatzes, je nachdem, was höher ist (Artikel 99 Abs. 4 lit. G KI-VO).

- Unterlassungs- und Schadensersatzanspruch wegen unwahrer Tatsachenbehauptung: Einen Hinweis auf den Ursprung als KI-Bild sollten Sie unabhängig von der KI-VO schon heute führen, wenn ein KI-Bild, das eine Person abbildet, für echt gehalten werden könnte. Damit wäre das Bild eine unwahre Tatsache anzusehen. Wenn Sie es verbreiten, dann könnten die betroffene Person, Unternehmen oder Organisation Unterlassung und Schadensersatz verlangen.

- Verleumdung: Wenn ein Deepfake geeignet ist, eine Person verächtlich zu machen oder in der öffentlichen Meinung herabzuwürdigen oder wirtschaftlich zu schaden, dann droht Ihnen bei Verbreitung eine Bestrafung wegen Verleumdung mit bis zu 2 Jahren Freiheitsstrafe oder Geldstrafe (§ 188 StGB).

Die Regelung zur Pflicht zur Kennzeichnung von Deepfakes beinhaltet die folgenden Milderung und Ausnahme:

- Milderung der Transparenzpflicht bei Kunst, Satire, Fiktion oder analoge Werke und Memes: Ist der Inhalt Teil eines offensichtlich künstlerischen, kreativen, satirischen, fiktionalen oder analogen Werks oder Programms, so beschränken sich die Transparenzpflichten darauf, das Vorhandensein solcher erzeugten oder manipulierten Inhalte in geeigneter Weise offenzulegen. Wobei diese Offenlegung die Darstellung oder den Genuss des Werks nicht beeinträchtigen darf. Was diese Ausnahme genau bedeutet, werden Gerichte bestimmen müssen. So kommen z.B. Hinweise auf den Einsatz von KI in der Selbstbeschreibung einer Künstlerin als hinreichende Kennzeichnung in Frage..

- Ausnahmen für KI-generierte News: Wenn Betreiber von KI-Systemen Texte veröffentlichen, die die Öffentlichkeit über wichtige Themen informieren sollen, müssen sie klarstellen, dass diese Texte von einer KI erzeugt oder verändert wurden. Diese Pflicht entfällt nur, wenn die Texte dazu dienen, Verbrechen aufzudecken oder zu verhindern, oder wenn die KI-Texte von Menschen überprüft und kontrolliert werden und jemand die Verantwortung für die Veröffentlichung übernimmt.

Strafbarkeit wegen Deepfakes: Seitens der Politik werden bereits weitere Gesetzesvorschläge unterbreitet (Bayern, Bundesrat Drucksache 222/24), wie der Missbrauch von Deepfakes in erheblichen Fällen mittels des Strafrechts vorgebeugt werden könnte. In einem neuen § 201b Abs. 1 StGB soll die Verletzung von Persönlichkeitsrechten durch das Zugänglichmachen von manipulierten oder künstlich erzeugten Medieninhalten mit bis zu zwei Jahren Freiheitsstrafe oder einer Geldstrafe geahndet werden.

Pflicht zur KI-Kompetenz (Instruktion und Schulung von Mitarbeitern)

Der Gesetzgeber sieht eine generelle Pflicht zur KI Kompetenz vor (Artikel 4 KI-VO, Hervorhebungen vom Verfasser):

Die Anbieter und Betreiber von KI‑Systemen ergreifen Maßnahmen, um nach besten Kräften sicherzustellen, dass ihr Personal und andere Personen, die in ihrem Auftrag mit dem Betrieb und der Nutzung von KI‑Systemen befasst sind, über ein ausreichendes Maß an KI‑Kompetenz verfügen, wobei ihre technischen Kenntnisse, ihre Erfahrung, ihre Ausbildung und Schulung und der Kontext, in dem die KI‑Systeme eingesetzt werden sollen, sowie die Personen oder Personengruppen, bei denen die KI‑Systeme eingesetzt werden sollen, zu berücksichtigen sind.

Was KI-Kompetenz ist, wird wiederum im Artikel 3 Nr. 56 der KI-VO definiert (Hervorhebungen vom Verfasser):

„KI‑Kompetenz“ die Fähigkeiten, die Kenntnisse und das Verständnis, die es Anbietern, Betreibern und Betroffenen unter Berücksichtigung ihrer jeweiligen Rechte und Pflichten im Rahmen dieser Verordnung ermöglichen, KI‑Systeme sachkundig einzusetzen sowie sich der Chancen und Risiken von KI und möglicher Schäden, die sie verursachen kann, bewusst zu werden.

Die Pflicht zur KI-Kompetenz umfasst:

- Technische Kenntnisse: Anbieter und Betreiber müssen sicherstellen, dass ihr Personal über ausreichende technische Kenntnisse im Umgang mit KI-Systemen verfügt.

- Bewusstsein der Risiken und möglicher Schäden: Ebenso müssen sie nicht nur die Vorzüge, sondern auch mögliche von der KI ausgehende Risiken und mit ihnen zusammenhängende Pflichten kennen. Zum Beispiel wissen, dass Deepfakes als KI-Erzeugnisse gekennzeichnet werden müssen.;

- Erfahrung und Fähigkeiten: Personen, die KI-Systeme nutzen, müssen die notwendige Erfahrung haben, um die KI-Systeme verstehen und entsprechend der KI-VO kontrollieren zu können.

- Ausbildung und Schulung: Anbieter und Betreiber müssen Instruktionen und Schulungen anbieten, die dem Kontext der Nutzung der KI-Systeme entsprechen.

- Kontext und Risiko im Einzelfall prüfen: Die Art und der Umfang der vorstehenden Pflichten muss im Einzelfall bestimmt werden. So wird zum Beispiel im Fall der Content-Erstellung eine schriftliche Unterweisung und Verpflichtung von Mitarbeitenden, Deepfakes als solche zu kennzeichnen, ausreichen; bei der Entwicklung eines KI-Systems für das Personalmanagement werden die Entwickler eine direkte und persönliche Unterweisung und attestierte berufliche Kompetenz oder entsprechende Schulungen vorweisen müssen, um zum Beispiel Fälle von Diskriminierung oder Datenschutzverstößen zu vermeiden.

Das bedeutet, bevor Sie KI im Unternehmen einführen, müssen Sie entsprechend der KI-Verordnung dafür sorgen, dass Ihre Mitarbeiter die nötigen Kenntnisse für den Umgang mit der KI haben. Sind diese Kenntnisse nicht vorhanden, haften die für die Compliance zuständigen Personen wie z.B. Geschäftsführer oder leitende Angestellte auch persönlich.

Welche Gesetze müssen neben der KI-VO beim KI-Einsatz beachtet werden?

Die KI-Verordnung ist ein Spezialgesetz, das den Einsatz von KI regelt. Das bedeutet, dass andere Gesetze dadurch nicht verdrängt werden (solange sie nicht spezielle KI-Eigenheiten regeln). Zu den zusätzlich geltenden Gesetzen gehören insbesondere:

- DSGVO: Wenn im Rahmen der Nutzung von KI personenbezogene Daten verarbeitet werden, müssen auch die Vorgaben der Datenschutzgrundverordnung beachtet werden. Das ist bereits der Fall, wenn zum Beispiel Mitarbeiter KI-Systeme einsetzen.

- Geschäftsgeheimnisschutzgesetz: Geschäftsgeheimnisse werden nur dann vom Gesetz geschützt, wenn sie gegen ungewollte Offenbarung angemessen geschützt werden (§ 2 Abs. 1 b) GeschGehG). Daher müssen zum Beispiel Mitarbeiter, die mit Geschäftsgeheimnissen umgehen, darauf verpflichtet werden, dass sie Geschäftsgeheimnisse nicht an eine fremde KI übermitteln.

- Urheberrecht: Wenn zur Schulung von KI-Systemen widerrechtlich fremde urheberrechtlich geschützte Werke verwendet werden, dann liegt ein Urheberrechtsverstoß vor.

- Persönlichkeitsrechte: Wenn zum Beispiel mittels KI Abbildungen von prominenten Personen erstellt und veröffentlicht werden, dann liegen darin, sofern es sich nicht um zulässige Karikaturen o.ä. handelt, Verletzungen von Persönlichkeitsrechten vor.

- Wettbewerbs- und Markenrecht: Wenn eine KI zum Beispiel Werbebotschaften mit wettbewerbswidrigen Inhalten generiert und zum Beispiel unbelegte Superlative wie “Wir sind die Besten” oder Marken von Wettbewerbern verwendet, dann haften die Nutzer dieser Ergebnisse für die damit einhergehenden Rechtsverstöße.

Diese Beispiele zeigen, dass die Vorgaben der KI-Verordnung bisherige Prüfungspflichten nicht ersetzen, sondern zu diesen zusätzlich hinzutreten. Dabei müssen ganz besonders die Datenschutzvorgaben beachtet werden.

Verpflichtung Ihrer Mitarbeitenden auf den Datenschutz und Schutz von Geschäftsgeheimnissen: Mit Hilfe unserer KI-Richtlinien für Mitarbeitende werden Ihre Mitarbeitenden auf die Einhaltung des Schutzes von Geschäftsgeheimnissen und Datenschutzes, speziell beim KI-Einsatz, verpflichtet. Daneben empfehlen wir, Mitarbeitende generell auf die Einhaltung von Geschäftsgeheimnissen als auch des Datenschutzes zu verpflichten.

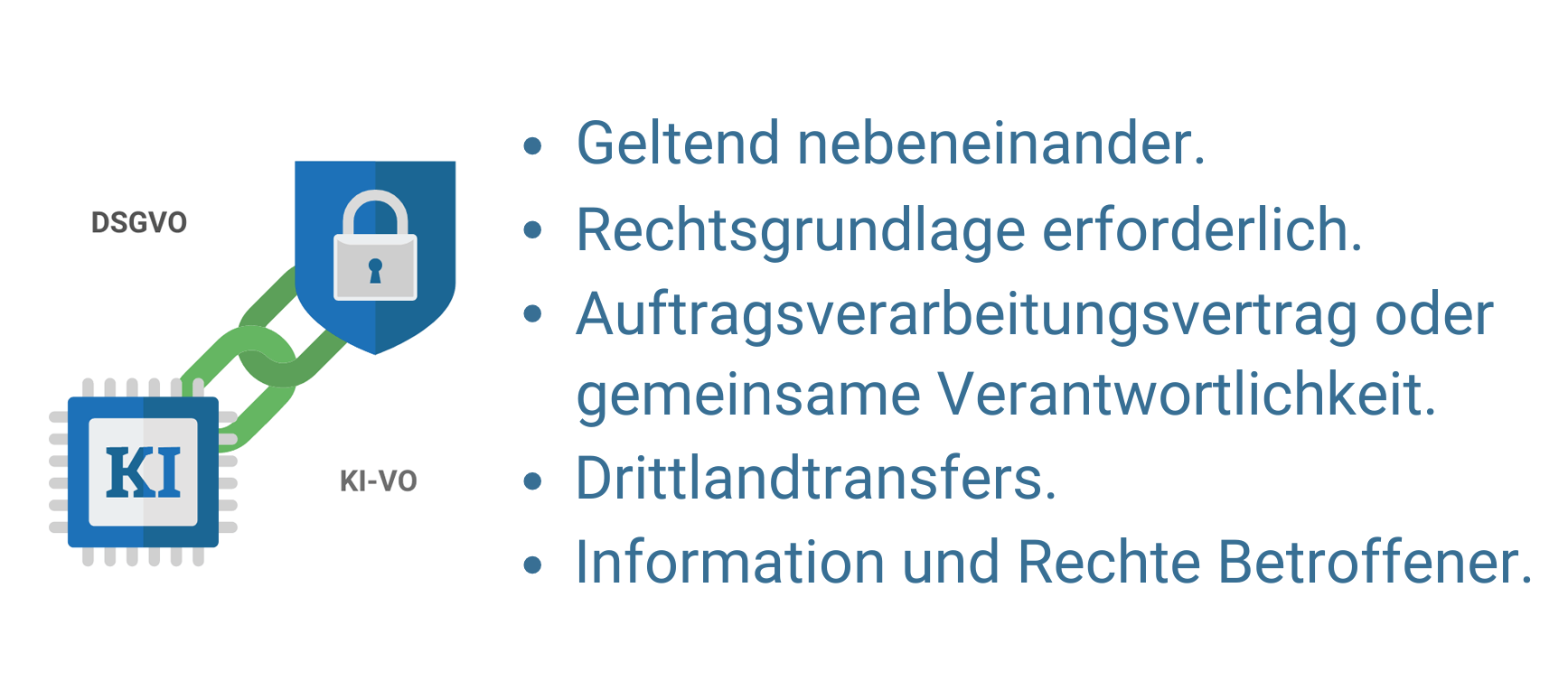

Wie verhält sich die KI-VO im Verhältnis zur DSGVO?

Die KI-VO und die DSGVO ergänzen sich gegenseitig, da sie verschiedene, aber miteinander verknüpfte Aspekte der Nutzung von KI-Systemen regeln (Artikel 2 Abs. 7 KI-VO). Beispiel der Prüfungsreihenfolge im Fall des Einsatzes von Biometrischen Gesichtserkennung:

- KI-VO: Eine Biometrischen Gesichtserkennung kann je nach Art des Einsatzes eine Verbotene KI-Praktik sein, wenn sie z.B. die Kreditwürdigkeit anhand der Ethnie der Menschen beurteilen. Sie kann aber auch grundsätzlich zulässig sein, z.B. wenn sie der Emotionserkennung von Beschäftigten dienen würde. In dem Fall müssten zwar die Pflichten als Hochrisiko-KI-System beachtet werden, aber der Einsatz wäre laut der KI-VO erlaubt.

- DSGVO: Auch wenn die biometrische Gesichtserkennung nach der KI-VO sein sollte, bedarf sie einer Erlaubnisgrundlage nach der DSGVO (z.B. Einwilligung oder berechtigte Interessen), der Information der Betroffenen, Aufnahme in ein Verzeichnis von Verarbeitungstätigkeiten, Durchführung einer Datenschutz-Folgenabschätzung etc., um auch datenschutzrechtlich zulässig zu sein.

Sofern nicht gerade Hochrisiko-KI-Systeme eingesetzt werden, ist in der Praxis davon auszugehen, dass in der Regel die DSGVO für die meisten Unternehmen beim Einsatz von KI-Systemen weiterhin die größte Rolle spielen wird. Im Rahmen des Einsatzes von Hochrisiko-KI-Systemen, muss die DSGVO ohnehin als eine Voraussetzung ihres Einsatzes beachtet werden müssen.

Ratgeber zur KI und DSGVO: Weitere Informationen und Details zu datenschutzrechtlichen Aspekten von Künstlicher Intelligenz erhalten Sie in unserem Ratgeber “KI & Datenschutz – Checkliste für den Einsatz künstlicher Intelligenz“. Eine Checkliste zur Prüfung der datenschutzrechtlichen Aspekte finden Sie ferner am Ende dieses Beitrags.

Muss der KI-Einsatz dokumentiert werden?

Sollten Sie den Einsatz von KI immer dokumentieren, sei es entsprechend der KI-Verordnung, der DSGVO oder generell, um bei potenziellen Rechtsverstößen nachweisen zu können, dass Sie die KI-Systeme geprüft und “im Blick haben”:

- Vorgabe bei Hochrisiko-KI-Systemen: Die KI-VO enthält nur im Fall von Hochrisiko-KI-Systemen eine Pflicht zur Führung von speziellen technischen Dokumentationen, Aufzeichnungen und Protokollen. Im Übrigen wird kein spezielles Verzeichnis von KI-Prozessen verlangt.

- Pflicht aus der DSGVO: Wenn im Rahmen des KI-Einsatzes personenbezogene Daten verarbeitet werden, dann muss die entsprechende Dokumentation ohnehin zur Erfüllung der Rechenschaftspflicht aus Art. 5 Abs. 2 DSGVO erfolgen.

- Compliance-Gebot: Sollte sich herausstellen, dass es sich zum Beispiel doch um ein Hochrisiko-KI-System gehandelt haben sollte oder sollte ein Datenschutzvorfall eintreten, dann sollten Sie davon ausgehen, im Zweifel nachweisen zu müssen, dass Sie entsprechende Prüfungen durchgeführt und die Risiken abgewogen haben. Das heißt, die Dokumentation erfolgt zu Ihrem eigenen Schutz.

Compliance: Der Begriff der Compliance bedeutet so viel wie die Einhaltung aller gesetzlichen und internen unternehmerischen Regeln. Der Begriff wird vor allem im Zusammenhang mit der persönlichen Haftung von Geschäftsführern oder leitenden Angestellten verwendet, zu deren Aufgaben es gehört, für eine Compliance zu sorgen. Dazu gehört zum Beispiel die Instruktion, Unterrichtung und Schulung von Mitarbeitern, die Bestellung von Datenschutzbeauftragten usw. bzw. die Delegation und Überprüfung der Einhaltung dieser Pflichten.

Muss ein Verzeichnis von KI-Systemen geführt werden?

Die KI-VO enthält keine generelle Verpflichtung, alle KI-Prozesse in einem speziellen Verzeichnis zu führen.

Allerdings gilt auch hier das oben zur Dokumentation des KI-Einsatzes Gesagte. Aus Gründen des Nachweises und vor allem, weil es in der Regel ohnehin aufgrund der DSGVO erforderlich sein wird, sollten Sie die von Ihnen verwendeten KI-Systeme in Ihrem Verzeichnis von Verarbeitungstätigkeiten führen.

Die KI-Verordnung und die DSGVO sind zwei sich ergänzende Gesetze, und daher spricht nichts dagegen, dass Angaben zum verwendeten KI-System auch im Verzeichnis von Verarbeitungstätigkeiten entsprechend der DSGVO aufgenommen werden.

Muss eine “KI-Erklärung” bereitgestellt werden?

Die KI-VO sieht keine generelle “KI-Erklärung” ähnlich einer Datenschutzerklärung vor. Daher werden sich die Informationspflichten betreffend den Einsatz von KI-Systemen vorrangig aus der DSGVO und nur in bestimmten Fällen aus der KI-VO ergeben:

- KI-VO: Im Fall des Einsatzes von Hochrisiko-KI-Systemen am Arbeitsplatz sind die Arbeitnehmer und deren etwaige Vertretung hierüber vorab zu informieren (Artikel 26 Abs. 7 KI-VO).

- DSGVO: Die DSGVO sieht in Art. 13 insbesondere vor, dass betroffene Personen über die Zwecke der Verarbeitung, Empfänger personenbezogener Daten oder Grundlagen der Transfers außerhalb der EU informiert werden, was in der Datenschutzerklärung erfolgen kann.

Auch im Fall der Informationspflichten sollten Sie zu Ihrer Sicherheit stets zuerst davon ausgehen, dass die von Ihnen verwendeten KI-Systeme zumindest in der Datenschutzerklärung aufgenommen werden müssen. Das gilt ganz besonders, wenn Sie ein Hochrisiko-KI-System einsetzen.

Welche Sanktionen drohen bei Verstoß gegen die KI-Verordnung?

Mit 35 Mio. oder 7% vom weltweiten Jahresumsatz liegen die DSGVO-Bußgelder über dem Bußgeld nach der DSGVO, das bis zu 20 Mio. oder 4% vom weltweiten Jahresumsatz betragen kann (Art. 83 DSGVO). Liegen Verstöße gegen beide Gesetze vor, wird das strengere Gesetz die Höchstgrenze für das Bußgeld vorgeben, aber im Rahmen der Berechnung wird auch Einheitlichkeit der Handlung zu berücksichtigen sein, sodass nicht mit einer Addition der Beträge zu rechnen ist, wenn der Verstoß ähnlicher Natur ist.Die KI-Verordnung sieht ein dreistufiges Sanktionskonzept vor, das je nach Schwere des Verstoßes unterschiedliche Bußgelder vorsieht (Artikel 99 Abs. 3 bis 5 KI-VO):

- 35 Millionen Euro oder 7 % des weltweiten Jahresumsatzes, je nachdem, was höher ist: Das höchste Bußgeld droht, wenn verbotene KI-Systeme gemäß Artikel 5 der KI-Verordnung eingesetzt werden oder die Qualitätskriterien für verwendete Daten bei Hochrisiko-KI-Systemen gemäß Artikel 10 der KI-Verordnung nicht erfüllt werden.

- 15 Millionen Euro oder 3 % des weltweiten Jahresumsatzes, je nachdem, was höher ist: Ein Bußgeld immerhin auf dem höchsten Niveau der DSGVO droht z.B., wenn Sie Hochrisiko-KI-Systeme einsetzen, ohne die nötigen technischen und organisatorischen Mittel zu treffen oder keine KI-Beauftragten zu bestimmen, aber auch bei fehlender Kennzeichnung von Deepfakes.

- 7,5 Millionen Euro oder 1,0 % des weltweiten Jahresumsatzes, je nachdem, was höher ist: Ein immer noch beträchtliches Bußgeld droht, wenn falsche Informationen gegenüber den zuständigen Stellen oder Behörden erteilt werden.

Diese Sanktionen richten sich nach der Schwere des Verstoßes und sind so konzipiert, dass sie sowohl abschreckend wirken als auch eine Angemessenheit in Relation zur Größe und dem Umsatz eines Unternehmens wahren sollen.

Bußgeldmilderung für KMUs und Start-Ups: Im Falle von KMU, einschließlich Start-up-Unternehmen, gilt für jede in diesem Artikel genannte Geldbuße der jeweils niedrigere Betrag aus den in den Absätzen 3, 4 und 5 genannten Prozentsätzen oder Summen (Artikel 99 Abs. 6 KI-VO).

Wie werden Bußgelder nach dem KI-Act berechnet?

Die Bußgelder sollen im Verhältnis zu dem konkreten Verstoß verhängt werden. Das heißt, dass eine Einzelperson, die ein Deepfake nicht kennzeichnet, je nach Umstand mit eher geringerem Bußgeld im dreistelligen Bereich, ein politisch agierendes Presseunternehmen dagegen ein Bußgeld in der Maximalhöhe erhalten könnte.

Die Ermittlung der Bußgeldhöhe erfolgt zuerst in zwei Schritten:

- Bußgeldrahmen: Zunächst wird der passende Bußgeldrahmen festgelegt (35 Mio. und 7% vom Umsatz oder 15 Mio., bzw. 3% vom Umsatz, oder 7,5 Mio., bzw. 1% vom Umsatz).

- Konkrete Bußgeldhöhe: Im zweiten Schritt wird die konkrete Höhe des Bußgeldes innerhalb dieses Rahmens bestimmt.

Bei der Bestimmung der konkreten Bußgeldhöhe werden die folgenden Faktoren berücksichtigt (Artikel 99 Abs. 7 KI-VO):

- Art, Schwere und Dauer des Verstoßes: Diese Aspekte bestimmen maßgeblich, wie gravierend der Verstoß ist und wie lange er angedauert hat.

- Folgen des Verstoßes: Die direkten und indirekten Auswirkungen des Verstoßes werden analysiert.

- Bußgelder anderer Marktüberwachungsbehörden: Bußgelder, die für denselben Verstoß von anderen Behörden verhängt wurden, werden in die Entscheidung einbezogen.

- Größe und Marktanteil des Unternehmens: Größere Unternehmen mit größerem Marktanteil können höhere Bußgelder auferlegt bekommen.

- Interessen von Kleinanbietern und Start-Ups: Die wirtschaftliche Leistungsfähigkeit dieser kleineren Akteure wird besonders berücksichtigt.

- Vorsätzlichkeit oder Fahrlässigkeit des Verstoßes: Es wird berücksichtigt, ob der Verstoß vorsätzlich oder fahrlässig begangen wurde.

- Alle Maßnahmen, die der Akteur ergriffen hat, um den Schaden, der den betroffenen Personen zugefügt wird, zu mindern: Es wird bewertet, welche Maßnahmen das Unternehmen ergriffen hat, um den Schaden für die Betroffenen zu verringern.

- Maßnahmen zur Minderung des Schadens: Ob und inwieweit das Unternehmen nach dem Verstoß Maßnahmen ergriffen hat, um den entstandenen Schaden zu mindern.

- Grad der Zusammenarbeit mit den Behörden: Die Bereitschaft und der Umfang der Zusammenarbeit des Unternehmens mit den zuständigen Behörden während der Untersuchung.

- Frühere Verstöße des Unternehmens: Frühere Verstöße des Unternehmens werden bei der Bemessung des Bußgeldes berücksichtigt.

- Grad der Einhaltung der Anordnungen: Wie weitgehend das Unternehmen Anordnungen der Marktüberwachungsbehörden befolgt hat.

- Grad an Verantwortung des Akteurs unter Berücksichtigung der von ihm ergriffenen technischen und organisatorischen Maßnahmen: Die Verantwortung des Akteurs wird unter Berücksichtigung der Maßnahmen bewertet, die er zur Vermeidung von Verstößen ergriffen hat.

- Art und Weise, wie der Verstoß den zuständigen nationalen Behörden bekannt wurde, insbesondere ob und gegebenenfalls in welchem Umfang der Akteur den Verstoß gemeldet hat: Es wird berücksichtigt, wie der Verstoß bekannt wurde und ob der Akteur den Verstoß selbst gemeldet hat.

Welche Behörden sorgt für die Durchsetzung der KI-VO?

Die Durchsetzung der KI-VO erfolgt auf mehreren Ebenen:

- EU-Kommission:

- Zuständig für die Überwachung und Durchsetzung auf EU-Ebene.

- Handelt bei grenzüberschreitenden Sachverhalten oder systemischen Verstößen.

- Kann Untersuchungen durchführen und Sanktionen verhängen, besonders bei allgemeinen KI-Systemen mit systemischen Risiken.

- Nationale Behörden:

- Überwachen und setzen die KI-VO innerhalb ihrer Länder um.

- Ahnden lokale Verstöße und sorgen für die Einhaltung der Vorgaben durch Unternehmen.

- Aufgaben umfassen die Überprüfung von Hochrisiko-KI-Systemen, Konformitätsbewertungen und die Registrierung in der EU-Datenbank.

Als nationale Behörde ist in Deutschland die Bundesnetzagentur für die Durchsetzung des KI-Acts zuständig.

Ab wann gilt die KI-VO?

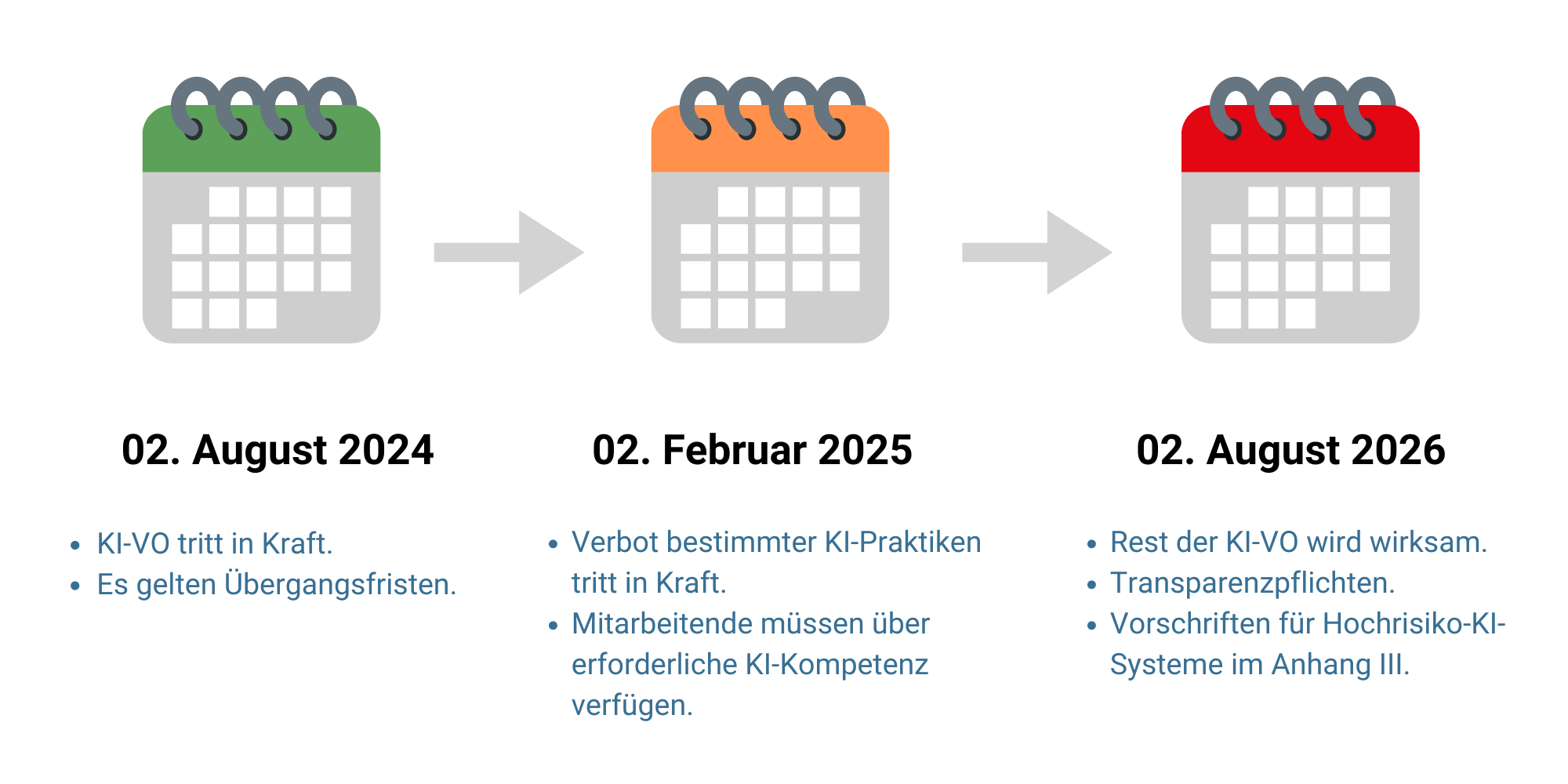

Die EU-KI-Verordnung (AI Act) setzt verschiedene Umsetzungsfristen fest, die sich nach den Risikokategorien und Arten der KI richten (Artikel 113 KI-VO). Die wichtigsten Termine umfassen:

- 2. August 2024: Die KI-VO tritt in Kraft, aber mit den im folgenden genannten Übergangsfristen.

- 02. Februar 2025: Verbotene KI-Praktiken gem. Art. 5 KI-VO sind nicht mehr erlaubt und mit KI beschäftigtes Personal muss die nötige Sachkunde aufweisen (“KI-Kompetenz” in Artikel 4).

- 02. Mai 2025: Das KI-Büro wird die Verhaltenskodizes abschließen, die die Verpflichtungen für Entwickler und Betreiber von KI-Systemen abdecken. Diese Kodizes bieten freiwillige Richtlinien für die verantwortungsvolle Entwicklung und Nutzung von KI.

- 02. August 2025: Die Europäische Kommission wird Durchführungsakte für Anbieter von Hochrisiko-KI erlassen. Organisationen, die Hochrisiko-KI-Systeme verwenden, müssen eine standardisierte Vorlage zur Überwachung dieser Systeme nach deren Einsatz befolgen. Der Überwachungsplan soll sicherstellen, dass alle Probleme oder Risiken schnell identifiziert und behoben werden.

- 02. August 2026: Der Rest der KI-Verordnung wird wirksam, einschließlich der Vorschriften für Hochrisiko-KI-Systeme, die in Anhang III der Verordnung aufgeführt sind, sowie den Transparenzpflichten. Diese Systeme umfassen biometrische Technologien wie Fingerabdruckerkennung, Gesichtserkennung, Iris-Scanning und Spracherkennung.

- 02. August 2027: Die Vorschriften für Hochrisiko-KI-Systeme, die in Anhang I der KI-VO festgelegt sind, treten in Kraft.

Bitte beachten Sie, dass diese Zeitlinie nur für die KI-VO gilt: Die Vorgaben der DSGVO für den Einsatz von KI gelten bereits heute, sodass KI-Systeme nicht ohne Vorprüfung in Unternehmen eingesetzt werden dürfen. Ferner mag es erst ab August 2026 notwendig werden, Risikoprüfungen für Hochrisiko-KI-Systeme durchzuführen. Wenn diese KI-Systeme personenbezogene Daten verarbeiten, dann müssen ohnehin Datenschutz-Folgenabschätzungen erstellt und Datenschutzbeauftragte mit Kenntnis der Verarbeitungsvorgänge und Risiken der KI bestellt werden, was sich größtenteils auch mit der Fachkenntnis der KI-Beauftragten überlappen wird.

Checkliste für Betreiber von KI-Systemen gemäß EU-KI-Verordnung (KI-VO)

1. Handelt es sich um ein KI-System im Sinne der KI-VO?

- Ist das System maschinengestützt und lernfähig?

- Arbeitet das System autonom und verarbeitet Eingaben, um Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen zu erzeugen?

- Praxis-Tipp: Wenn “KI” draufsteht, wird es in der Regel KI sein.

2. Handelt es sich um keine verbotene KI-Praktik?

- Unterschwellige Beeinflussung: Wird das System eingesetzt, um das Verhalten einer Person oder Personengruppe durch unterschwellige Techniken wesentlich zu beeinflussen und kann dadurch erhebliche Schäden zu verursachen?

- Ausnutzung von Schwächen: Nutzt das System Schwächen von Personen aufgrund von Alter, Behinderung oder sozialer und wirtschaftlicher Situation aus, um das Verhalten zu beeinflussen und erhebliche Schäden zu verursachen?

- Soziale Bewertung: Bewertet das System Personen über einen bestimmten Zeitraum basierend auf ihrem Sozialverhalten oder persönlichen Eigenschaften?

- Vorhersage krimineller Aktivitäten: Bewertet oder sagt das System das Risiko vorher, dass eine Person eine Straftat begeht, basierend auf Profiling und Persönlichkeitsmerkmalen?

- Erstellung von Gesichtsdatenbanken: Wird das KI-System eingesetzt, um ohne spezifischen Zweck oder Anlass Gesichtsdatenbanken zu erstellen oder zu erweitern, indem Bilder aus dem Internet oder von Überwachungskameras ausgelesen werden?

- Emotionserkennung am Arbeitsplatz: Erfasst das System Emotionen am Arbeitsplatz oder in Bildungseinrichtungen ohne medizinische oder sicherheitstechnische Gründe?

- Biometrische Kategorisierung: Kategorisiert das System Personen auf Grundlage biometrischer Daten in Bezug auf Rasse, politische Meinungen, religiöse Überzeugungen, etc.?

3. Handelt es sich um ein Hochrisiko-KI-System?

- Biometrische Fernidentifizierung: Wird das System zur biometrischen Fernidentifizierung in öffentlichen Bereichen verwendet?

- Emotionserkennung: Erfasst das System Emotionen am Arbeitsplatz oder in öffentlichen Räumen?

- Kritische Infrastruktur: Wird das System zur Verwaltung und Betrieb kritischer digitaler Infrastruktur eingesetzt?

- Bildung: Nutzt das System automatisierte Bewertungsmechanismen in Bildungseinrichtungen?

- Beschäftigung: Unterstützt das System die Einstellung, Beförderung oder Kündigung von Arbeitsverhältnissen?

- Kreditwürdigkeitsprüfung: Bewertet das System Kreditanträge bei Banken?

- Strafverfolgung: Nutzt das System Lügendetektoren oder risikobasierte Strafverfolgungsmethoden?

- Migration und Grenzkontrolle: Analysiert das System Asylanträge oder identifiziert Sicherheitsrisiken an Grenzen?

- Rechtspflege: Unterstützt das System rechtliche Entscheidungen oder beeinflusst Wahlergebnisse?

4. Anforderungen an Betreiber von Hochrisiko-KI-Systemen:

- Betriebsanleitung und Maßnahmen: Sicherstellen, dass das System gemäß den Betriebsanleitungen verwendet wird und technische sowie organisatorische Maßnahmen implementiert sind.

- Kompetente Aufsicht: Gewährleisten, dass die menschliche Aufsicht durch geschulte und befugte Personen erfolgt.

- Datenkontrolle: Sicherstellen, dass die Eingabedaten korrekt sind und der Zweckbestimmung entsprechen.

- Überwachung und Berichterstattung: Kontinuierliche Überwachung der Systeme und Meldung von Risiken oder Vorfällen.

- Protokollaufbewahrung: Automatisch erzeugte Protokolle für mindestens sechs Monate speichern.

- Information der Arbeitnehmer: Arbeitnehmer und deren Vertretung über den Einsatz informieren.

- Registrierungspflichten: Einhaltung der Registrierungspflichten gemäß Artikel 49.

- Datenschutz-Folgenabschätzung: Durchführung von Datenschutz-Folgenabschätzungen gemäß Art. 35 DSGVO.

5. Anforderungen an Betreiber aller KI-Systeme:

- Interaktion: Anbieter müssen Nutzer informieren, dass sie mit einem KI-System interagieren.

- Kennzeichnung: Anbieter müssen KI-Ergebnisse in maschinenlesbarem Format kennzeichnen.

- Deepfakes: Wer Deepfakes erstellt, also Bild-, Ton- oder Videoinhalte künstlich erzeugt oder manipuliert muss die Deepfakes als “KI-Erzeugnisse” kennzeichnen.

- KI-Kompetenz: Es muss sichergestellt sein, z.B. durch Instruktionen und Schulungen, dass Personal über ausreichende technische Kenntnisse und Erfahrungen verfügt.

- Führung eines KI-Verzeichnisses: Dokumentation der eingesetzten KI-Systeme, z.B. in einem Verzeichnis von Verarbeitungstätigkeiten gemäß DSGVO, um im Zweifel nachweisen zu können, dass die Compliance geprüft und eingehalten wurde.

- Beachtung der DSGVO: Sicherstellen, dass alle datenschutzrechtlichen Vorgaben beachtet werden (Vorliegen einer Einwilligung oder sonstige Erlaubnisgrundlage, Datenschutzerklärung, Führung im Verzeichnis von Verarbeitungstätigkeiten).

- Geschäftsgeheimnisschutzgesetz: Schutz von Geschäftsgeheimnissen sicherstellen.

- Urheberrecht und Persönlichkeitsrechte: Urheberrechtliche und Persönlichkeitsrechte Dritter bei Schulung und Nutzung von KI-Systemen beachten.

- Wettbewerbs- und Markenrecht: Vermeidung von wettbewerbswidrigen Inhalten und Markenrechtsverletzungen durch KI-Erzeugnisse.

10. Sanktionen bei Verstößen beachten:

- Bis zu 15 Mio. Euro oder 3% des Jahresumsatzes für Betreiber.

- Abmahnungen und Schadensersatz bei Verletzung von Datenschutz-, Persönlichkeits-, Urheber-, Marken- und Wettbewerbsrechten.

- Bußgelder bei Verletzung der KI-VO (Bis zu 15 Mio. Euro oder 3% des Jahresumsatzes für Betreiber von KI-Systemen) und der DSGVO (Bis zu 20 Mio. Euro oder 4% des Jahresumsatzes für Verantwortliche, d.h. Betreiber)

Checkliste der Datenschutzkonferenz für den Einsatz von KI-Anwendungen

Das Gremium aller deutschen Datenschutzbehörden, die Datenschutzkonferenz (“DSK”), hat in der Orientierungshilfe “Künstliche Intelligenz und Datenschutz – Version 1.0” die in der folgenden Checkliste zusammengefassten Prüfungsschritte für den praktischen Einsatz von KI-Anwendungen empfohlen:

- Konzeption des Einsatzes und Auswahl von KI-Anwendungen

- Einsatzfelder und Zwecke bestimmen: Vor der Nutzung muss festgelegt werden, für welche Zwecke die jeweilige KI-Anwendung eingesetzt wird.

- Rechtmäßige Einsatzfelder: Überprüfung, ob die Einsatzfelder rechtmäßig und im Einklang mit der DSGVO sind.

- Verzicht auf personenbezogene Daten: Bewertung, ob der Einsatz ohne personenbezogene Daten möglich ist.

- Datenschutzkonformes Training von KI-Anwendungen: Sicherstellen, dass das Training der KI datenschutzkonform erfolgt.

- Rechtsgrundlage für die Datenverarbeitung: Festlegung der Rechtsgrundlage für die Verarbeitung personenbezogener Daten.

- Keine automatisierte Letztentscheidung: Sicherstellen, dass keine automatisierten Entscheidungen ohne menschliche Überprüfung getroffen werden.

- Geschlossenes oder offenes System: Entscheidung, ob ein geschlossenes oder offenes KI-System verwendet wird, wobei geschlossene Systeme, z.B. für beschränkte Anwender zugänglich, nicht-öffentlich, als sicherer eingestuft werden.

- Transparenz: Gewährleistung von Transparenz in Bezug auf die Funktionsweise der KI.

- Transparenz und Wahlmöglichkeit hinsichtlich KI-Training: Informationen und Wahlmöglichkeiten für Nutzer hinsichtlich des KI-Trainings bereitstellen.

- Transparenz und Wahlmöglichkeit hinsichtlich Eingabe-Historie: Transparenz und Wahlmöglichkeiten bezüglich der Speicherung und Nutzung der Eingabe-Historie bieten.

- Berichtigung, Löschung und weitere Betroffenenrechte: Sicherstellung der Rechte auf Berichtigung, Löschung und andere Betroffenenrechte.

- Datenschutzbeauftragte und Beschäftigtenvertretung einbinden: Einbindung von Datenschutzbeauftragten und der Beschäftigtenvertretung in den Prozess.

- Implementierung von KI-Anwendungen

- Verantwortlichkeit festlegen und verbindlich regeln: Festlegung und verbindliche Regelung der Verantwortlichkeiten.

- Interne Regelungen treffen: Entwicklung und Implementierung interner Datenschutzregelungen.

- Datenschutz-Folgenabschätzung: Durchführung einer Datenschutz-Folgenabschätzung (DSFA) [wobei die Orientierungshilfe nicht auf den Umstand eingeht, dass eine DSFA nicht bei jedem KI-Einsatz zur Anwendung kommt].

- Beschäftigte schützen, betriebliche Accounts einrichten: Schutz der Beschäftigten und Einrichtung betrieblicher Accounts.

- Datenschutz durch Technikgestaltung und durch datenschutzfreundliche Voreinstellungen: Umsetzung von Datenschutz durch Technikgestaltung und datenschutzfreundliche Voreinstellungen.

- Datensicherheit: Gewährleistung der Datensicherheit.

- Beschäftigte sensibilisieren: Sensibilisierung der Beschäftigten für Datenschutzthemen.

- Weitere Entwicklungen verfolgen: Fortlaufende Verfolgung und Anpassung an neue Entwicklungen im Datenschutz.

- Nutzung von KI-Anwendungen

- Vorsicht bei Eingabe und Ausgabe personenbezogener Daten: Vorsicht bei der Eingabe und Ausgabe personenbezogener Daten walten lassen.

- Besondere Vorsicht bei besonderen Kategorien personenbezogener Daten: Besondere Vorsicht bei der Verarbeitung besonderer Kategorien personenbezogener Daten.

- Ergebnisse auf Richtigkeit prüfen: Überprüfung der Ergebnisse der KI-Anwendung auf Richtigkeit.

- Ergebnisse und Verfahren auf Diskriminierung prüfen: Überprüfung der Ergebnisse und Verfahren auf mögliche Diskriminierung.

Für detaillierte Informationen können Sie die vollständige Orientierungshilfe auf der DSK-Website einsehen.

Lesetipp zu KI und Datenschutz: Ebenso empfehlen wir Ihnen unseren Ratgeber KI & Datenschutz – Checkliste für den Einsatz künstlicher Intelligenz.

Fazit und Praxistipp

Aufgrund des Umstands, dass Künstliche Intelligenz (KI) zunehmend in alle Bereiche Einzug hält, sei es als Unterstützung bei der täglichen Korrespondenz, Buchhaltung oder Erstellung von Marketingmaterialien, wird die Prüfung der KI-Verordnung (KI-VO) ebenso zur Pflicht vor jedem Einsatz von Software wie die Prüfung der DSGVO.

Dabei könnte die Prüfung durchaus mit der DSGVO beginnen, denn was nach der DSGVO zulässig ist, wird in der Regel auch nach der KI-VO erlaubt sein. Umgekehrt sind jedoch nicht alle Verfahren, die nach der KI-VO erlaubt sind, automatisch auch nach der DSGVO zulässig.

In jedem Fall gehen mit den Vorteilen von KI auch rechtliche Fallstricke einher. Angesichts der potenziell hohen Bußgelder sollten Sie auf jeden Fall vor jedem KI-Einsatz die vorstehende Checkliste beachten.

Tipp für mehr Rechtssicherheit